本章数学问题太过复杂,建议去看看李宏毅老师这部分的内容,在此只贴出部分关于PPO的知识总结。

基于on-policy的policy gradient有什么可改进之处?或者说其效率较低的原因在于?

经典policy gradient的大部分时间花在sample data处,即当我们的agent与环境做了交互后,我们就要进行policy model的更新。但是对于一个回合我们仅能更新policy model一次,更新完后我们就要花时间去重新collect data,然后才能再次进行如上的更新。

所以我们的可以自然而然地想到,使用off-policy方法使用另一个不同的policy和actor,与环境进行互动并用collect data进行原先的policy的更新。这样等价于使用同一组data,在同一个回合,我们对于整个的policy model更新了多次,这样会更加有效率。

使用important sampling时需要注意的问题有哪些。

我们可以在important sampling中将 pp 替换为任意的 qq,但是本质上需要要求两者的分布不能差的太多,即使我们补偿了不同数据分布的权重,当我们对于两者的采样次数都比较多时,最终的结果时一样的,没有影响的。但是通常我们不会取理想的数量的sample data,所以如果两者的分布相差较大,最后结果的variance差距(平方级)将会很大。

基于off-policy的importance sampling中的 data 是从 θ \theta θ’sample 出来的,从 θ \theta θ 换成 θ ′ \theta' θ′ 有什么优势?

使用off-policy的importance sampling后,我们不用 \thetaθ 去跟环境做互动,假设有另外一个 policy θ ′ \theta' θ′ ,它就是另外一个actor。它的工作是他要去做demonstration, θ ′ \theta' θ′的工作是要去示范给 θ \theta θ 看。它去跟环境做互动,告诉 $\theta$ 说,它跟环境做互动会发生什么事。然后,借此来训练\thetaθ。我们要训练的是 θ \theta θ , θ ′ \theta' θ′只是负责做 demo,负责跟环境做互动,所以 sample 出来的东西跟 \thetaθ 本身是没有关系的。所以你就可以让 θ ′ \theta' θ′做互动 sample 一大堆的data,\thetaθ 可以update 参数很多次。然后一直到 \thetaθ train 到一定的程度,update 很多次以后, θ ′ \theta' θ′再重新去做 sample,这就是 on-policy 换成 off-policy 的妙用。

在本节中PPO中的KL divergence指的是什么

本质来说,KL divergence是一个function,其度量的是两个action (对应的参数分别为

θ

\theta

θ 和

θ

′

\theta'

θ′ )间的行为上的差距,而不是参数上的差距。这里行为上的差距(behavior distance)可以理解为在相同的state的情况下,输出的action的差距(他们的概率分布上的差距),这里的概率分布即为KL divergence。

请问什么是重要性采样呀?

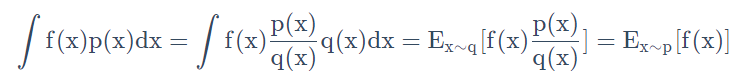

使用另外一种数据分布,来逼近所求分布的一种方法,算是一种期望修正的方法,公式是:

我们在已知 q的分布后,可以使用上述公式计算出从 p 分布的期望值。也就可以使用 q 来对于 p 进行采样了,即为重要性采样。

请问on-policy跟off-policy的区别是什么?

on-policy:生成样本的policy(value function)跟网络更新参数时使用的policy(value function)相同。典型为SARAS算法,基于当前的policy直接执行一次动作选择,然后用这个样本更新当前的policy,因此生成样本的policy和学习时的policy相同,算法为on-policy算法。该方法会遭遇探索-利用的矛盾,光利用目前已知的最优选择,可能学不到最优解,收敛到局部最优,而加入探索又降低了学习效率。epsilon-greedy 算法是这种矛盾下的折衷。优点是直接了当,速度快,劣势是不一定找到最优策略。

请简述下PPO算法。其与TRPO算法有何关系呢?

PO算法的提出:旨在借鉴TRPO算法,使用一阶优化,在采样效率、算法表现,以及实现和调试的复杂度之间取得了新的平衡。这是因为PPO会在每一次迭代中尝试计算新的策略,让损失函数最小化,并且保证每一次新计算出的策略能够和原策略相差不大。具体来说,在避免使用important sampling时由于在

θ

\theta

θ 下的 p$\theta$ (at | st)跟 在

θ

′

\theta'

θ′下的 p $\theta’$ (at | st)差太多,导致important sampling结果偏差较大而采取的算法。