文章目录

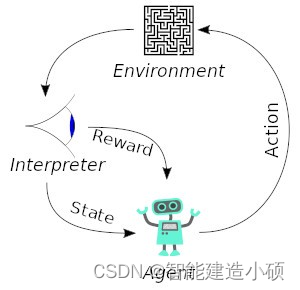

在 强化学习 (RL)中,代理人接受奖励和 惩罚机制的培训。智能 体因正确的动作而获得奖励,并因错误的动作而受到惩罚。这样做时,智能体会尽量减少错误的动作并最大化正确的动作。

本文将分享强化学习的一些实际应用。

1.在自动驾驶汽车中的应用

各种论文提出了用于自动驾驶的深度强化学习。在自动驾驶汽车中,有许多方面需要考虑,例如不同地方的限速、可行驶区域、避免碰撞——仅举几例。

可以应用强化学习的一些自动驾驶任务包括轨迹优化、运动规划、动态路径、控制器优化和基于场景的高速公路学习策略。

例如,可以通过学习自动停车策略来实现停车。变道可以使用Q-Learning来实现,而超车可以通过学习超车策略来实现,同时避免碰撞并保持稳定的速度。

AWS DeepRacer是一款自动驾驶赛车,旨在在物理赛道上测试 RL。它使用摄像头来可视化跑道,并使用强化学习模型来控制油门和方向。

Wayve.ai 已成功将强化学习应用于训练汽车如何在一天内驾驶。 他们使用深度强化学习算法来解决车道跟随任务。他们的网络架构是一个具有 4 个卷积层和 3 个全连接层的深度网络。下面的示例显示了车道跟随任务。中间的图像代表驾驶员的视角。

视频链接

https://neptune.ai/wp-content/uploads/2022/11/10-Real-Life-Applications-of-Reinforcement-Learning.mp4

2.强化学习的行业自动化

在工业强化中,基于学习的机器人被用来执行各种任务。除了这些机器人比人类更有效率之外,它们还可以执行对人类有危险的任务。

一个很好的例子是 Deepmind 使用人工智能代理来冷却谷歌数据中心。这导致能源支出减少了 40% 。这些中心现在完全由人工智能系统控制,无需人工干预。显然还有来自数据中心专家的监督。该系统以下列方式工作:

- 每五分钟从数据中心拍摄一次数据快照,并将其提供给深度神经网络

- 然后它预测不同的组合将如何影响未来的能源消耗

- 识别将导致最低功耗的操作,同时保持一组安全标准标准

- 在数据中心发送和实施这些操作

这些动作由本地控制系统验证。

3.强化学习在贸易和金融中的应用

监督时间序列(论文:https://arxiv.org/ftp/arxiv/papers/1803/1803.03916.pdf)模型可用于预测未来销售以及预测股票价格。但是,这些模型并不能确定在特定股票价格下采取的行动。输入强化学习 (RL)。RL 代理可以决定这样的任务;是持有、买入还是卖出。RL 模型使用市场基准标准进行评估,以确保其性能最佳。

这种自动化为流程带来了一致性,这与以前的方法不同,在以前的方法中,分析师必须做出每一个决定。例如, IBM有一个复杂的基于强化学习的平台,能够进行金融交易。它根据每笔金融交易的损失或利润计算奖励函数。

4.NLP(自然语言处理)中的强化学习

在 NLP 中,RL 可用于文本摘要、问答和**机器翻译,**仅举几例。

这篇论文:https://homes.cs.washington.edu/~eunsol/papers/acl17eunsol.pdf,作者 Eunsol Choi、Daniel Hewlett 和 Jakob Uszkoreit 提出了一种基于 RL 的方法来回答给定长文本的问题。他们的方法首先从文档中选择几个与回答问题相关的句子。然后使用慢速 RNN 来生成所选句子的答案。

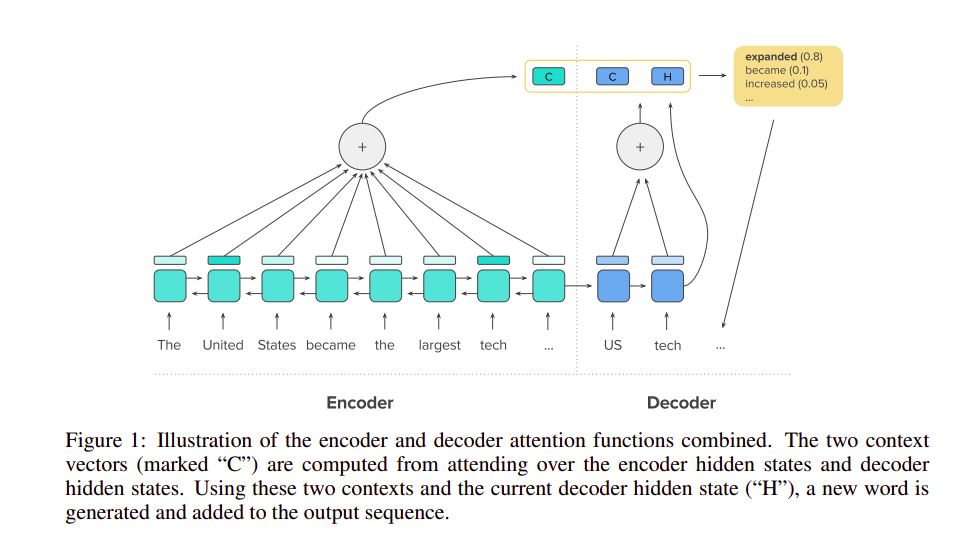

论文:https://arxiv.org/pdf/1705.04304.pdf,结合监督学习和强化学习进行抽象文本摘要。该论文由 Romain Paulus、Caiming Xiong 和 Richard Socher 领衔。他们的目标是解决在较长文档中使用基于 RNN 的编码器-解码器模型时在摘要中面临的问题。本文的作者提出了一种具有新颖内部注意力的神经网络,它关注输入并连续单独生成输出。他们的训练方法是标准的监督词预测和强化学习的组合。

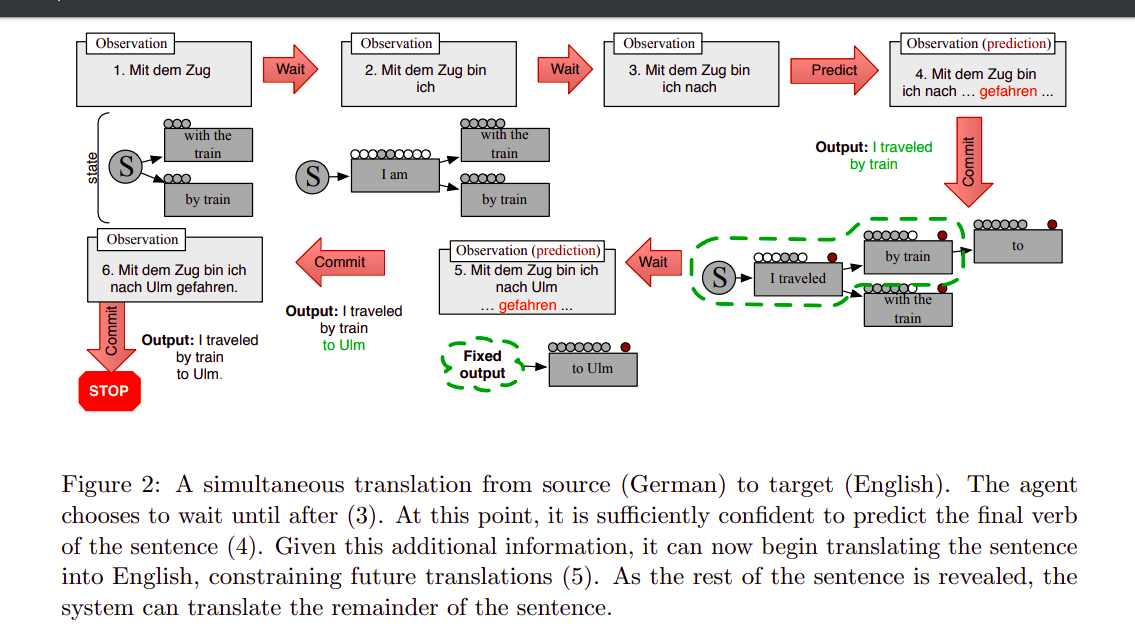

在机器翻译方面,论文:http://users.umiacs.umd.edu/~jbg/docs/2014_emnlp_simtrans.pdf提出了一种基于强化学习的同步机器翻译方法。这项工作的有趣之处在于它有能力学习何时信任预测的单词并使用 RL 来确定何时等待更多输入。

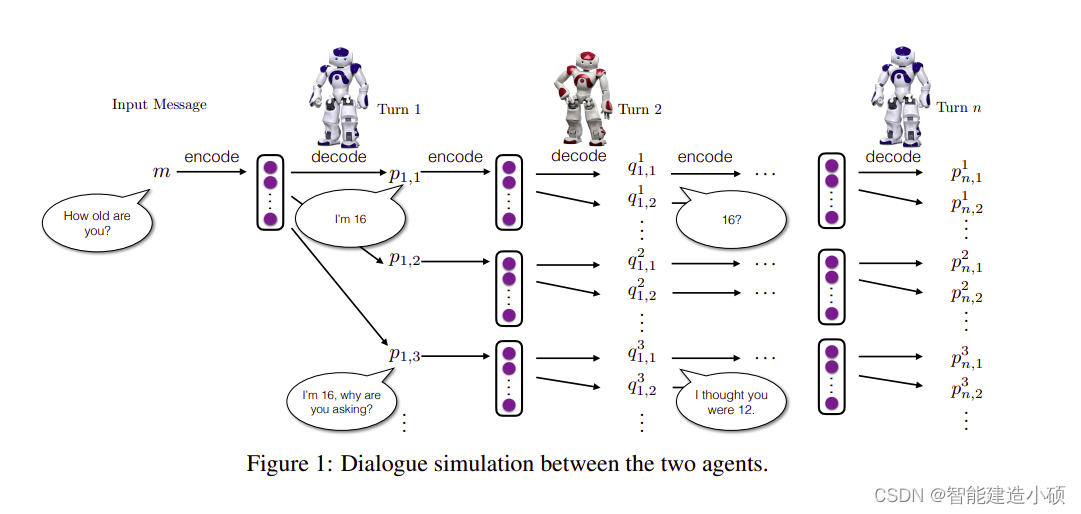

来自斯坦福大学、俄亥俄州立大学和微软研究院的研究人员已经将深度强化学习用于对话生成:https://arxiv.org/pdf/1606.01541.pdf。深度强化学习可用于为聊天机器人对话中的未来奖励建模。 使用两个虚拟代理模拟对话。策略梯度方法用于奖励包含重要对话属性(例如连贯性、信息量和易于回答)的序列。

5.强化学习在医疗保健中的应用

在医疗保健领域,患者可以根据从 RL 系统学习的策略接受治疗。RL 能够使用以前的经验找到最优策略,而不需要有关生物系统数学模型的先前信息。它使这种方法比医疗保健中其他基于控制的系统更适用。

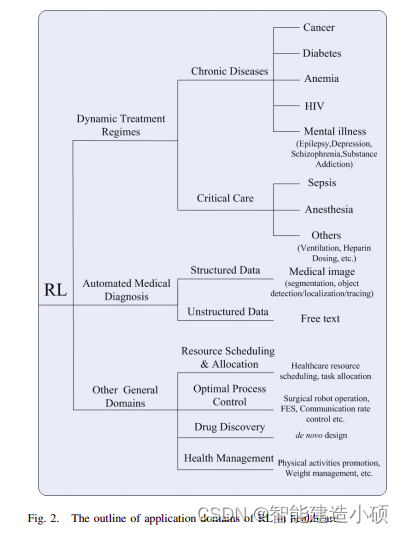

医疗保健中的 RL 被归类为慢性病或重症监护、自动化医学诊断和其他一般领域中的动态治疗方案 (DTR) :https://arxiv.org/pdf/1908.08796.pdf

在 DTR 中,输入是一组对患者的临床观察和评估。输出是每个阶段的治疗方案。这些类似于 RL 中的状态。RL 在 DTR 中的应用是有利的,因为它能够确定时间相关的决策,以便在特定时间为患者提供最佳治疗。

在医疗保健中使用RL(论文:https://arxiv.org/pdf/1908.08796.pdf)还可以通过考虑治疗的延迟效应来改善长期结果。

RL 还被用于发现和生成慢性病的最佳 DTR。

您可以通过浏览论文:https://arxiv.org/pdf/1908.08796.pdf,更深入地了解 RL 在医疗保健中的应用。

6.强化学习在工程中的应用

在工程前沿,Facebook 开发了一个开源的强化学习平台 ——Horizon(https://engineering.fb.com/ml-applications/horizon/)。该平台使用强化学习来优化大规模生产系统。Facebook 在内部使用了 Horizon:

- 个性化建议

- 向用户发送更有意义的通知

- 优化视频流质量。

Horizon 还包含以下工作流:

- 模拟环境

- 用于数据预处理的分布式平台

- 在生产中训练和导出模型。

视频显示中强化学习的一个经典示例是根据视频缓冲区的状态和来自其他机器学习系统的估计为用户提供低或高比特率视频。

Horizon 能够处理类似生产的问题,例如:

- 大规模部署

- 特征归一化

- 分布式学习

- 服务和处理具有高维数据和数千种特征类型的数据集。

7.新闻推荐中的强化学习

用户偏好可能会经常变化,因此根据评论和喜欢向用户**推荐新闻可能很快就会过时。**论文(http://www.personal.psu.edu/~gjz5038/paper/www2018_reinforceRec/www2018_reinforceRec.pdf)通过强化学习,RL 系统可以跟踪读者的返回行为。

构建这样一个系统将涉及获取新闻特征、读者特征、上下文特征和读者新闻特征。新闻特征包括但不限于内容、标题和发布者。读者特征是指读者如何与内容交互,例如点击和分享。上下文特征包括新闻方面,例如新闻的时间和新鲜度。然后根据这些用户行为定义奖励。

8.游戏中的强化学习

让我们看一下游戏前沿的应用程序,特别是AlphaGo Zero。使用强化学习,AlphaGo Zero 能够从头开始学习围棋游戏。它通过与自己对战来学习。经过 40 天的自我训练,Alpha Go Zero 已经超越了击败世界第一柯洁的被称为Master的 Alpha Go 版本(https://deepmind.com/alphago-china)。它仅使用棋盘上的黑白棋子作为输入特征和单个神经网络。依赖于单个神经网络的简单树搜索用于评估位置移动和样本移动,而无需使用任何Monte Carlorollouts。

9.实时出价——强化学习在营销和广告中的应用

论文(https://arxiv.org/pdf/1802.09756.pdf)中,作者提出了使用多代理强化学习进行实时竞价。 使用聚类方法处理大量广告商的处理,并为每个聚类分配一个战略投标代理。为了平衡广告商之间的竞争与合作之间的权衡,提出了分布式协调多代理投标(DCMAB)。

在营销中,准确定位个人的能力非常关键。这是因为正确的目标显然会带来高投资回报。淘宝——中国最大的电子商务平台,所提出的方法优于最先进的单代理强化学习方法。

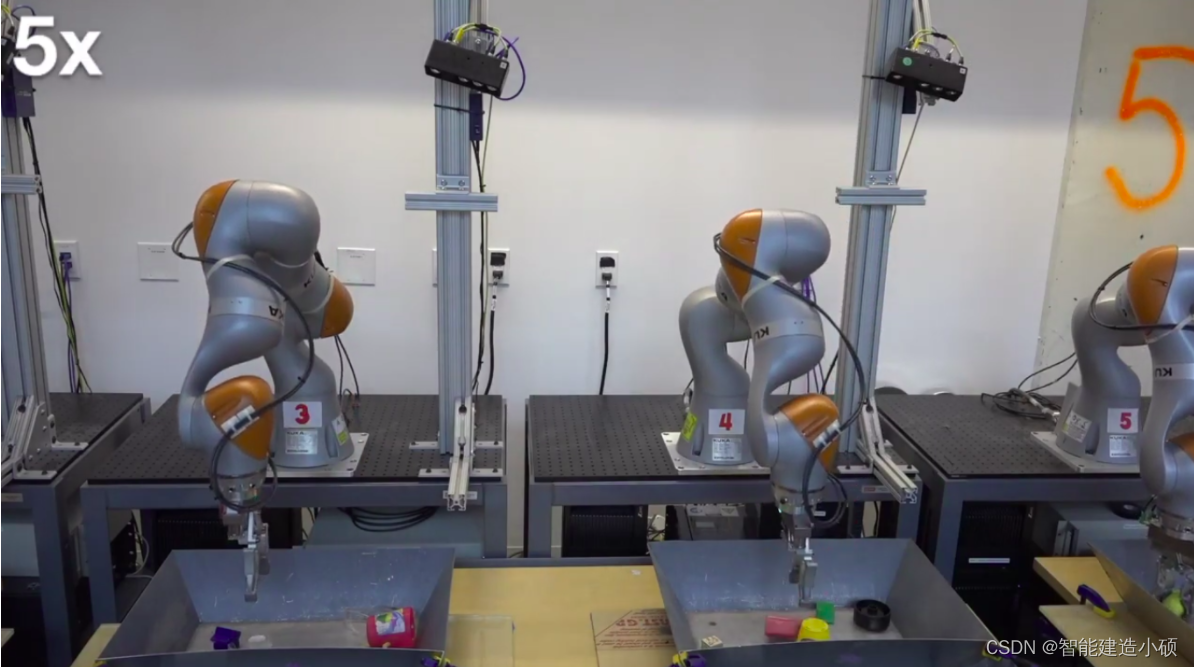

10.机器人操作中的强化学习

使用深度学习和强化学习可以训练能够抓住各种物体的机器人——甚至是那些在训练过程中看不到的物体。例如,这可以用于在装配线上构建产品。

这是通过结合大规模分布式优化和称为QT-Opt的深度 Q 学习的变体来实现的。QT-Opt 对连续动作空间的支持使其适用于机器人问题。首先对模型进行离线训练,然后在真实机器人上进行部署和微调。

谷歌 AI 将这种方法应用于机器人抓取,其中 7 个真实世界的机器人在 4 个月的时间内运行了 800 个机器人小时。

在此实验中,QT-Opt 方法在 700 次尝试抓取之前未见过的物体上的抓取尝试中取得了 96% 的成功。Google AI 之前的方法有 78% 的成功率。

强化学习仍然是一个非常活跃的研究领域,在推进该领域并将其应用于现实生活方面已经取得了重大进展,但依然有很多方面值得研究,强化学习还有巨大的应用潜力。

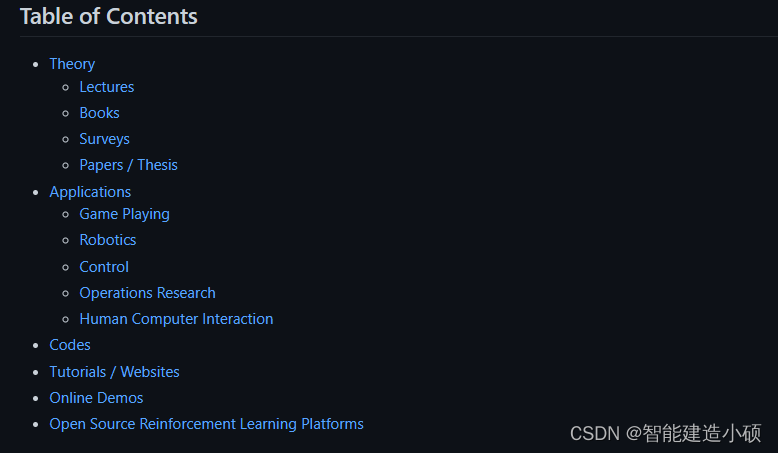

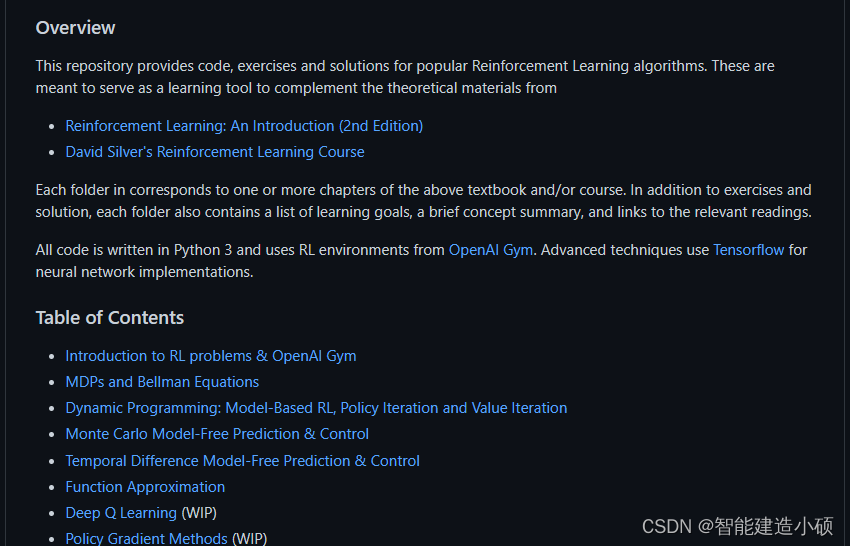

本文讲的十个应用只是对强化学习的一个简单了解,如果您想了解更多信息或者全面学习强化学习,请查看这个下面的几个GitHub仓库学习:

-

强化学习蘑菇书(强烈推荐):https://github.com/QHCV/easy-rl

-

https://github.com/aikorea/awesome-rl

-

https://github.com/dennybritz/reinforcement-learning

参考资料:https://neptune.ai/blog/reinforcement-learning-applications

希望有所帮助!喜欢就点个赞吧!