Article

文献题目:Decision Transformer: Reinforcement Learning via Sequence Modeling

文献时间:2021

摘要

- 我们引入了一个将强化学习(RL)抽象为序列建模问题的框架。 这使我们能够利用 Transformer 架构的简单性和可扩展性,以及 GPT-x 和 BERT 等语言建模的相关进步。 特别是,我们提出了决策转换器,一种将 RL 问题转换为条件序列建模的架构。 与先前的强化学习方法拟合值函数或计算策略梯度不同,Decision Transformer 只是通过利用因果屏蔽的 Transformer 来输出最佳动作。 通过对期望回报(奖励)、过去状态和行动的自回归模型进行调节,我们的决策转换器模型可以生成实现期望回报的未来行动。 尽管它很简单,但 Decision Transformer 在 Atari、OpenAI Gym 和 Key-to-Door 任务上的性能匹配或超过了最先进的无模型离线 RL 基线。

引言

- 最近的工作表明,transformers [1] 可以对语义概念的高维分布进行大规模建模,包括语言中的有效零样本泛化 [2] 和分布外图像生成 [3]。 鉴于此类模型成功应用的多样性,我们试图检查它们在形式化为强化学习 (RL) 的顺序决策问题中的应用。 与使用变压器作为传统 RL 算法 [4, 5] 中组件的架构选择的先前工作相比,我们试图研究生成轨迹建模——即对状态、动作和奖励序列的联合分布进行建模——是否可以替代传统的 RL 算法。

- 我们考虑了以下范式转变:我们将使用序列建模目标根据收集到的经验训练 Transformer 模型,而不是通过传统的 RL 算法(如时间差异(TD)学习 [6])来训练策略。 这将使我们能够绕过长期信用分配的引导需求——从而避免已知会破坏 RL 稳定的“致命三元组”[6]之一。 它还避免了像 TD 学习中通常所做的那样对未来奖励进行折扣的需要,这可能会导致不良的短视行为。 此外,我们可以利用现有的广泛用于语言和视觉的、易于扩展的 Transformer 框架,利用大量研究稳定训练 Transformer 模型的工作。

- 除了展示出对长序列进行建模的能力外,Transformer 还有其他优势。 Transformer可以通过自我注意直接执行信用分配,而贝尔曼备份则缓慢传播奖励并且容易产生“干扰”信号[7]。 这可以使Transformer在存在稀疏或分散注意力的奖励时仍然有效地工作。 最后,经验证据表明,Transformer 建模方法可以对广泛分布的行为进行建模,从而实现更好的泛化和迁移 [3]。

- 我们通过考虑离线 RL 来探索我们的假设,我们将从次优数据中为代理分配学习策略——从固定的、有限的经验中产生最大有效的行为。 由于错误传播和价值高估[8],这项任务传统上具有挑战性。 但是,在使用序列建模目标进行训练时,这是一项自然的任务。 通过在状态、动作和返回序列上训练自回归模型,我们将策略采样减少为自回归生成建模。 我们可以通过选择所需的返回令牌来指定策略的专业知识——查询哪些“技能”,作为生成的提示。

- 说明性的例子。 为了对我们的提议有一个直觉,考虑在有向图上找到最短路径的任务,这可以作为 RL 问题提出。 当代理在目标节点时奖励为 0,否则为 -1。 我们训练了一个 GPT [9] 模型来预测一系列返回结果(未来奖励的总和)、状态和动作中的下一个token。 仅在随机游走数据上进行训练——没有专家演示——我们可以在测试时通过添加一个先验来生成最优轨迹以产生最高可能的回报(参见附录中的更多细节和经验结果),然后通过条件生成相应的动作序列。因此,通过将序列建模工具与事后回报信息相结合,我们无需动态规划即可实现策略改进。

- 受此观察的启发,我们提出了决策转换器,我们使用 GPT 架构对轨迹进行自回归建模(如图 1 所示)。 我们通过在 Atari [10]、OpenAI Gym [11] 和 Key-to-Door [12] 环境中的离线 RL 基准上评估 Decision Transformer 来研究序列建模是否可以执行策略优化。 我们表明,在不使用动态编程的情况下,Decision Transformer 可以匹配或超过最先进的无模型离线 RL 算法的性能 [13、14]。 此外,在需要长期信用分配的任务中,Decision Transformer 的性能优于 RL 基线。 通过这项工作,我们旨在将序列建模和转换器与 RL 联系起来,并希望序列建模成为 RL 的强大算法范式。

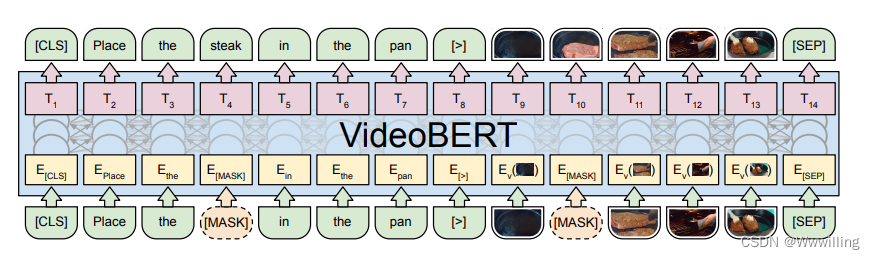

- 图 1:决策转换器架构。 状态、动作和奖励被输入到特定于模态的线性嵌入中,并添加了位置情节时间步长编码。 token被输入到 GPT 架构中,该架构使用因果自注意掩码自回归地预测动作。

- 我们的代码位于:https://sites.google.com/berkeley.edu/decision-transformer

预赛

离线强化学习

- 我们考虑在元组

(

S

,

A

,

P

,

R

)

(S, A, P, R)

(S,A,P,R) 描述的马尔可夫决策过程 (MDP) 中学习。 MDP 元组由状态

s

∈

S

s ∈ S

s∈S、动作

a

∈

A

a ∈ A

a∈A、转换动态

P

(

s

′

∣

s

,

a

)

P(s' |s, a)

P(s′∣s,a) 和奖励函数

r

=

R

(

s

,

a

)

r = R(s, a)

r=R(s,a) 组成。 我们使用

s

t

s_t

st、

a

t

a_t

at 和

r

t

=

R

(

s

t

,

a

t

)

r_t = R(s_t, a_t)

rt=R(st,at) 分别表示时间步

t

t

t 的状态、动作和奖励。 轨迹由一系列状态、动作和奖励组成:

τ

=

(

s

0

,

a

0

,

r

0

,

s

1

,

a

1

,

r

1

,

.

.

.

,

s

T

,

a

T

,

r

T

)

τ = (s_0, a_0, r_0, s_1, a_1, r_1, ... , s_T , a_T , r_T )

τ=(s0,a0,r0,s1,a1,r1,...,sT,aT,rT)。 在时间步

t

t

t 处返回的轨迹

是该时间步未来奖励的总和。 强化学习的目标是学习最大化 MDP 中的期望回报

的策略。 在离线强化学习中,我们只能访问一些固定的有限数据集,这些数据集由任意策略的轨迹滚动组成,而不是通过环境交互来获取数据。 此设置更难,因为它消除了代理探索环境和收集额外反馈的能力。

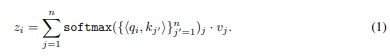

Transformer

- Vaswani 等人 [1] 提出了 Transformer 作为一种有效建模顺序数据的架构。 这些模型由带有残差连接的堆叠自注意力层组成。 每个自注意力层接收与唯一输入标记对应的

n

n

n 个嵌入

{

x

i

}

i

=

1

n

\{ x_i \} ^n _{i=1}

{xi}i=1n,并输出

n

n

n 个嵌入

{

z

i

}

i

=

1

n

\{z_i\}^ n_{ i=1}

{zi}i=1n,保留输入维度。 第

i

i

i 个标记通过线性变换映射到键

k

i

k_i

ki 、查询

q

i

q_i

qi 和值

v

i

v_i

vi 。 自注意力层的第

i

i

i 个输出是通过查询

q

i

q_i

qi 和其他键

k

j

k_j

kj 之间的归一化点积对值

v

j

v_j

vj 加权来给出的:

- 正如我们稍后将看到的,这允许层通过查询和键向量的相似性(最大化点积)隐式形成状态返回关联来分配“信用”。 在这项工作中,我们使用 GPT 架构 [9],它使用因果自注意掩码修改了Transformer架构以启用自回归生成,仅用序列中的前一个标记替换 n n n 个标记上的 summation/softmax ( j ∈ [ 1 , i ] j ∈ [1, i] j∈[1,i])。 我们将其他架构细节推迟到原始论文中。

方法

- 在本节中,我们介绍了决策Transformer,它在对Transformer架构进行最小修改的情况下对轨迹进行自回归建模,如图 1 和算法 1 所示。

- 轨迹表示。 我们选择轨迹表示的关键要求是它应该使Transformer能够学习有意义的模式,并且我们应该能够在测试时有条件地生成动作。 对奖励进行建模并非易事,因为我们希望模型根据未来期望的回报而不是过去的奖励来生成行动。 因此,我们不是直接提供奖励,而是为模型提供收益

。 这导致以下轨迹表示可以进行自回归训练和生成:

- 在测试时,我们可以指定所需的性能(例如 1 表示成功或 0 表示失败)以及环境起始状态,作为启动生成的条件信息。 在为当前状态执行生成的动作后,我们将目标回报减少获得的奖励并重复直到情节终止。

- 架构。 我们将最后的 K K K 个时间步输入到决策Transformer中,总共有 3 K 3K 3K 个token(每种模态一个:return-to-go、state 或 action)。 为了获得token嵌入,我们为每种模态学习了一个线性层,它将原始输入投影到嵌入维度,然后进行层归一化 [15]。 对于具有视觉输入的环境,状态被输入卷积编码器而不是线性层。 此外,每个时间步的嵌入都会被学习并添加到每个标记中——注意这与Transformer使用的标准位置嵌入不同,因为一个时间步对应于三个标记。 然后这些标记由 GPT [9] 模型处理,该模型通过自回归建模预测未来的动作标记。

- 训练。 我们得到了一个离线轨迹数据集。 我们从数据集中抽取序列长度为 K K K 的小批量。 对应于输入标记 s t s_t st 的预测头被训练来预测——离散动作的交叉熵损失或连续动作的均方误差——和平均每个时间步的损失。 我们并没有发现预测状态或收益来提高性能,尽管在我们的框架内很容易允许(如第 5.4 节所示)并且对于未来的工作来说这将是一项有趣的研究。

离线强化学习基准评估

- 在本节中,我们研究了 Decision Transformer 相对于专用离线 RL 和模仿学习算法的性能。 特别是,我们的主要比较点是基于 TD 学习的无模型离线 RL 算法,因为我们的决策转换器架构本质上也是无模型的。 此外,TD-learning 是 RL 中用于提高样本效率的主要范例,并且在许多基于模型的 RL 算法中作为子程序具有突出的特点 [16, 17]。 我们还与行为克隆和变体进行了比较,因为它还涉及类似于我们的基于可能性的策略学习公式。 确切的算法取决于环境,但我们的动机如下:

- TD 学习:这些方法中的大多数使用动作空间约束或价值悲观主义,将是与决策Transformer最忠实的比较,代表标准 RL 方法。 一种最先进的无模型方法是保守 Q 学习(CQL)[14],作为我们的主要比较。 此外,我们还与其他先前的无模型强化学习算法(如 BEAR [18] 和 BRAC [19])进行了比较。

- 模仿学习:该机制同样使用监督损失进行训练,而不是贝尔曼备份。 我们在这里使用行为克隆,并在第 5.1 节中包含更详细的讨论。

- 我们评估离散(Atari [10])和连续(OpenAI Gym [11])控制任务。 前者涉及高维观察空间,需要长期的学分分配,而后者需要细粒度的连续控制,代表着多样化的任务集。 我们的主要结果总结在图 3 中,其中我们显示了每个域的平均归一化性能。

- 图 3:Decision Transformer(我们的)与 TD 学习(CQL)以及 Atari、OpenAI Gym 和 Minigrid 的行为克隆的比较结果。 在各种任务上,Decision Transformer 的性能与传统方法相当或更好。 性能是通过标准化来衡量的

剧集回归(详见正文)。

Atari

- Atari 基准测试 [10] 具有挑战性,因为它的高维视觉输入以及由于动作和结果奖励之间的延迟而导致的信用分配困难。 根据 Agarwal 等人,我们在 DQN-replay 数据集中所有样本的 1% 上评估我们的方法。 [13],代表在线 DQN 代理 [20] 在训练期间观察到的 5000 万次转换中的 50 万次; 我们报告了 3 颗种子的平均值和标准差。 我们根据 Hafner 等人 [21] 的协议,根据职业玩家的分数对分数进行归一化,其中 100 代表职业玩家分数,0 代表随机策略。

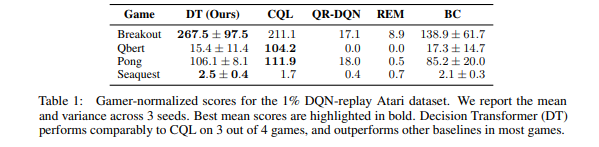

- 我们在 Agarwal 等人评估的四个 Atari 任务(Breakout、Qbert、Pong 和 Seaquest)上与 CQL [14]、REM [13] 和 QR-DQN [22] 进行比较。 [13]。 我们对 Decision Transformer 使用$ K = 30$ 的上下文长度(Pong 的 K = 50 除外)。 我们还报告了行为克隆 (BC) 的性能,它使用与决策Transformer相同的网络架构和超参数,但没有返回条件。 对于 CQL、REM 和 QR-DQN 基线,我们直接从 CQL 和 REM 论文中报告数字。 我们在表 1 中显示了结果。我们的方法在 4 场比赛中有 3 场与 CQL 具有竞争力,并且在所有 4 场比赛中都优于或匹配 REM、QR-DQN 和 BC。

- 我们还尝试像之前的工作一样使用

K

=

1

K = 1

K=1 的 MLP,但发现这比变压器更差。

- 表 1:1% DQN-replay Atari 数据集的玩家标准化分数。 我们报告了 3 个种子的均值和方差。 最佳平均分数以粗体突出显示。 决策Transformer (DT) 在 4 款游戏中的 3 款游戏中表现与 CQL 相当,并且在大多数游戏中优于其他基线。

OpenAI Gym

- 在本节中,我们考虑 D4RL 基准 [23] 中的连续控制任务。 我们还考虑了一个不属于基准测试的 2D 到达器环境,并使用与 D4RL 基准测试类似的方法生成数据集。 Reacher 是一个以目标为条件的任务,奖励稀少,因此它代表了与标准运动环境(HalfCheetah、Hopper 和 Walker)不同的设置。 不同的数据集设置如下所述。

- 中等:由“中等”策略生成的 100 万个时间步长,达到专家策略分数的大约三分之一。

- Medium-Replay:被训练以执行中等策略的代理的重播缓冲区(在我们的环境中大约 25k-400k 时间步长)。

- Medium-Expert:中等策略生成的 100 万个时间步长与专家策略生成的 100 万个时间步长相连接。

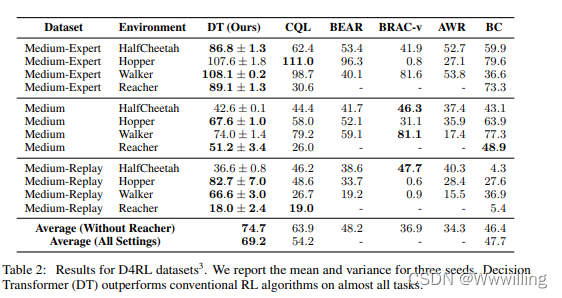

- 我们与 CQL [14]、BEAR [18]、BRAC [19] 和 AWR [24] 进行比较。 CQL 代表了无模型离线 RL 的最新技术,这是 TD 学习的一个实例,具有价值悲观主义。 根据 Fu 等人的说法,分数被归一化,因此 100 代表专家策略。 [23]。 CQL 数字是从原始论文中报告的; BC 号码由我们管理; 其他方法是从 D4RL 论文中报道的。 我们的结果如表 2 所示。Decision Transformer 在大多数任务中取得了最高分,并且在其余任务中与最先进的技术相媲美。

- 表 2:D4RL 数据集的结果。 我们报告了三个种子的均值和方差。 决策转换器 (DT) 在几乎所有任务上都优于传统的 RL 算法。

- 鉴于 CQL 通常是最强的 TD 学习方法,对于 Reacher,我们只运行 CQL 基线。

讨论

决策Transformer是否对数据子集执行行为克隆?

- 在本节中,我们试图深入了解 Decision Transformer 是否可以被认为是对具有一定回报的数据子集执行模仿学习。 为了研究这一点,我们提出了一种新方法,百分位行为克隆 (%BC),我们仅在数据集中前 X% 的时间步长上运行行为克隆,按情节返回排序。 百分位数 X% 在对整个数据集进行训练的标准 BC (X = 100%) 和仅克隆最佳观察轨迹 (X → 0%) 之间进行插值,在通过训练更多数据来更好地泛化与训练专注于所需数据子集的专用模型之间进行权衡。

…(未完)